« Les algorithmes sont présentés à tort comme objectifs »

La cofondatrice de l’Observatoire des algorithmes publics décrypte les causes et

conséquences du recours à l’intelligence artificielle (IA) dans l’administration.

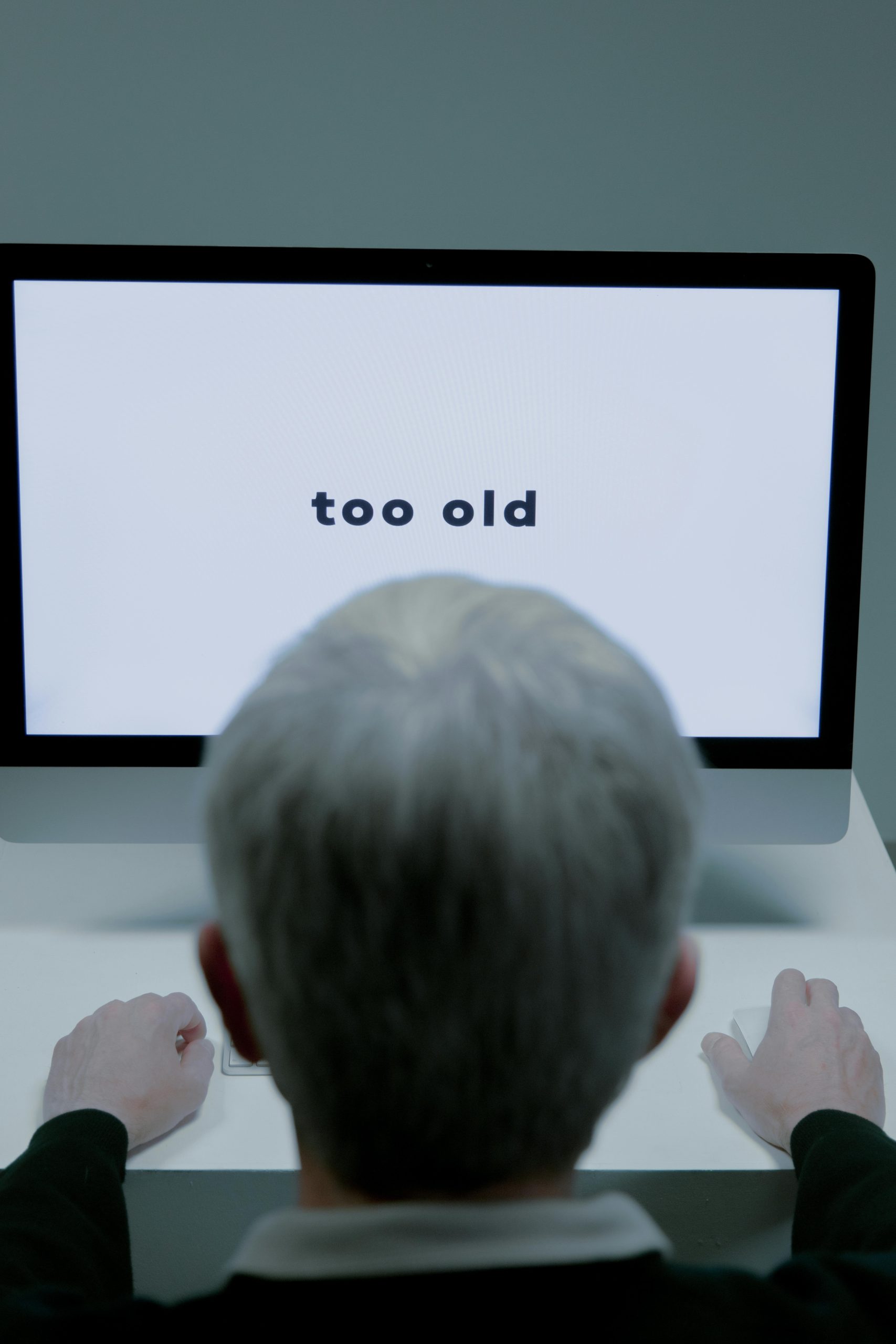

Les impôts sont loin d’être la seule administration à utiliser à l’intelligence artificielle (IA) : c’est aussi le cas de la Caisse nationale d’allocations familiales (Cnaf), de la gendarmerie, de la Cour de cassation… Comment expliquer ce recours accru ? Il repose entre autres sur l’opposition entre la « subjectivité humaine » et la supposée « objectivité » des algorithmes. Or se débarrasser de toute forme de subjectivité est impossible. Elle est simplement déplacée de l’agent vers les concepteurs de ces systèmes.

L’autre objectif, en recourant à l’IA, c’est la réduction des coûts. Mais il n’est jamais communiqué, car ces outils sont toujours présentés de manière positive. On sait néanmoins que ce n’est pas parce que les

réductions d’effectifs ne sont pas visibles aujourd’hui qu’elles ne se feront pas plus tard, une fois l’outil bien installé dans les routines professionnelles.

Vous dites que l’IA n’est pas aussi objective qu’elle n’en a l’air. En quoi ? Quand on parle de biais algorithmiques, on a tendance à ne penser qu’aux biais présents dans les jeux de données. Oui, bien sûr, un modèle d’IA va re‐produire les tendances et les stéréotypes des données sur lesquelles il aura été entraîné. Mais même au-delà de ça, tout, dans l’IA, est une affaire de choix. Les concepteurs peuvent tout à fait choisir qui ils ciblent en priorité, ou ne ciblent pas. Sauf que sous prétexte qu’il y a un algorithme, on s’attend à une sorte d’objectivité naturelle. Résultat, ceux qui déploient ces systèmes peuvent se garder d’expliciter les choix qui ont préludé à leur conception.

Sur le sujet, il y a un vrai manque de transparence. Les évaluations des systèmes d’IA déployés dans l’administration ne sont pas publiées, leur coût n’est pas documenté… Quant aux agents publics, concernés au premier chef, ils ne sont eux-mêmes pas informés des critères sur lesquels se basent ces outils censés les « aider à la décision ». Ce faisant, on dépossède les agents de leur regard critique sur les outils qu’on leur propose. Une partie des agents du fisc regrette en effet de ne pas savoir sur quels critères l’IA se base pour faire remonter tel ou tel dossier potentiellement frauduleux. Elle ne permet en

tout cas pas d’identifier les fraudes les plus importantes : les sommes que recouvre l’État par ce biais sont plutôt faibles.

Pourquoi ?

Si l’algorithme est programmé pour faire remonter le plus de dossiers possible en un minimum de temps, ce n’est pas très étonnant. Car les fraudes les plus importantes sont aussi les plus difficiles à détecter,

avec des structures plus complexes et une meilleure dissimulation. En tout cas, l’algorithme peut ne pas aller vers les mêmes cas que l’agent. Le risque est qu’on finisse par faire plus confiance à ses suggestions qu’à l’expertise des professionnels. Cela reviendrait à mettre la focale sur certains types de fraude et à déposséder les agents de leur expertise.

Pour remédier à l’opacité dont vous nous avez parlé, vous avez mis au point il y a un an un « inventaire des algorithmes publics », qui doit être actualisé ces jours-ci. Quelles en sont les tendances ?

Nous venons d’ajouter 48 algorithmes aux 72 que nous avions déjà répertoriés l’an dernier. Mais ces 120 cas ne constituent pas une liste exhaustive de l’IA dans le secteur public, puisque nous ne nous basons que sur des données publiques. C’est la partie émergée de l’iceberg. La tendance, cette année, c’est la prolifération dans l’administration de systèmes d’IA dite « générative », qu’il s’agisse de chatbots

(agents conversationnels), d’outils de traduction ou de transcription. Dans le cadre de la réforme de l’assurance-chômage, France Travail déploie par ailleurs beaucoup d’algorithmes ces temps-ci, notamment dans le cadre de la réforme de l’assurance-chômage. Ils visent notamment à orienter le contrôles des demandeurs d’emploi, par exemple s’ils sont inscrits dans un métier dit « en tension » ou

sur la base de leurs échanges avec France Travail. Même quand les systèmes ne sont pas présentés comme des systèmes de sanction, ils peuvent mener à une surveillance accrue des allocataires. ■

Recueilli par Mélinée Le Priol

Source : LA CROIX du 13 Novembre 2025